Pre-train과 Fine-tuning 용어가 많이 나오는데, 여기에서 Pre-train과 Fine-tuning 용어와 왜 Pre-train과 Fine-tuning이 필요한지 이해를 해보도록 하자.

언어 모델에서 사전 학습된 언어 모델(Pre-train Model)을 사용하는 이유

언어 모델에서 기본적으로 kobert 2b를 썼다... kobert 5b를 썼다는 등의 이야기를 많이 들을 수 있는데,

왜 내가 필요한 데이터만으로 넣지 않고, 많이 학습된 모델을 사용하는 것일까?

이유는 언어는 말, 사람으로 비교하자면, 내가 얼마나 많은 지식, 상식을 알고 있다면, 보다 다채로운 말을 구사할 수 있기 때문이다.

만약 10가지 문장을 학습하면, 10가지 문장내에서 선택이 이루어지게 되기 때문에, 다양한 말을 구사하기에는 한계가 있을 것이다.

즉 많은 단어와 문장을 학습할 수록 다양한 가중치를 가지고 선택할 수 있기 때문에 큰 언어 모델을 사용할 수록 풍부한 표현과 다채로운 문장을 구사할 가능성이 높아지는 것이다.

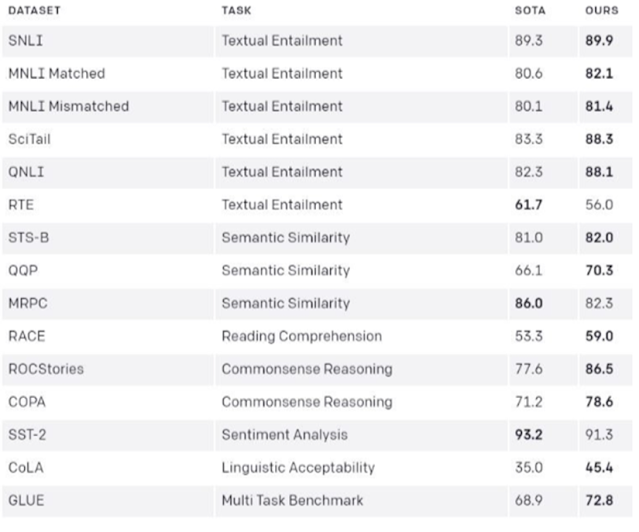

아래는 그림은 GPT 논문에서 2018년도에 발표한, SOTA(State of the art)와 비교했을때, GPT가 12개의 Task에서 좋은 성적을 나옴으로써, 각각 Task 맞게 개발하던 모델의 연구 방향을 단일 모델로 처리할 수 있다는 것을 증명하게 된 계기라고 할 수 있다.

GPT를 통해서 일반적인 언어에 대해 사전 학습이 잘되어 있으면, 우리가 필요로 하는 작업도 잘 진행한다는 것을 알게 되었는데, 문제는 자원이였다.

우리가 직접 이러한 학습 모델을 만들면 좋지만, 이러한 모델을 만드는데는 시간도 많이 필요하고 비용도 많이 필요하다고 할 수 있다. 특히 OpenAI에서 얘기하는 ChatGPT 하루 학습 비용이 9억이라고 하니... 일반인들은 접근하기가 쉽지 않은 영역이다.

즉 사전 학습 모델을 만들기 위해서는 많은 비용과 시간이 필요한데, 이를 일반적으로 공개한다는 것은 쉽지 않은 선택일 것이다. OpenAI 역시 GPT-2까지는 공개를 하였지만, GPT-3부터는 비공개로 전환하였고, Google 역시 지금은 비공개로 진행하는 것을 알 수 있다.

이렇게 최근에 공개를 하지 않는 분위기에서 Facebook의 행보는 만인의 사랑을 받을 만 하다.

최근 2023년 7월 Facebook은 Llama2를 공개하였다.

이렇게 공개된 모델을 이용하여, 자신에게 맞는 용도로 Fine-Tuning, 미세조정을 하여 사용하면 되겠다.

'Bigdata' 카테고리의 다른 글

| Masked Language Modeling(MLM) 모델 이해 (0) | 2024.08.11 |

|---|---|

| 딥러닝 - 뉴런(Neuron)이란? 개념 이해 (0) | 2024.08.11 |

| Transformers - 구조와 BERT, GPT 이해 (0) | 2024.08.11 |

| Python - Gaussian Error Linear Unit (GELU) 수식 - 코드 (0) | 2024.08.11 |

| LLM - fine-tuning GPT 계열 공식 이해 (0) | 2024.08.11 |