반응형

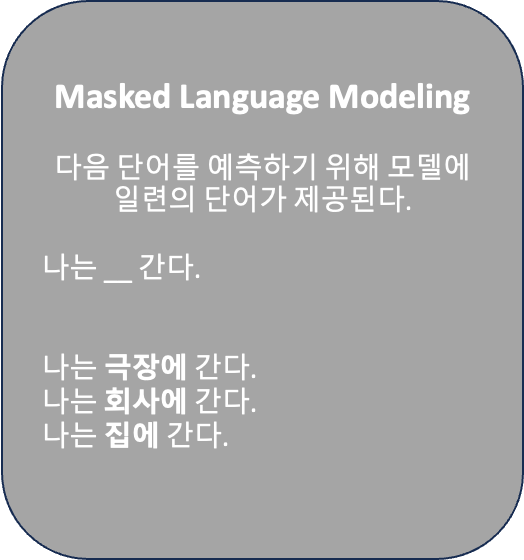

특정 단어를 Mask(숨김)후 이를 맞추는 모델로써,

BERT모델에서 사용 가능한 사전 학습 모델로, MLM(Masked Language Modeling)은 [MASK] 이전, 이후 정보를 모두 활용하여 사전 학습을 하는 양방향 학습 구조를 가진다.

입력된 문장에서 특정 단어를 [MASK] 한 후 맞추는 방식으로 학습을 진행하게 되는데, 입력된 문장에서 임의로 15% 단어를 선택하고 예측을 진행하게 된다. 이에 대해 다음과 같은 비율로 학습 규칙이 적용된다.

신경망에서 학습 되는 비율은 80% 단어에 대해 [MASK]를 진행하고, 10% 단어는 무작위로 변경되며, 나머지 10%는 유지되는 방식이다.

이렇게 전체를 [MASK] 하지 않으면, [MASK] 토큰이 파인 튜닝 단계에서는 나타나지 않으므로 사전 학습 단계와 파인 튜닝 단계에서의 불일치가 발생하는 문제를 해소 할 수 있다고...

MLM 모델은 문장 이해력이 좋기 때문에 분류에 큰 장점을 가진다는 것도 알아두면 좋다.

반응형

'Bigdata' 카테고리의 다른 글

| LoRA(Low-Rank Adaptation) - Fine-Tuning 최적화 (0) | 2024.08.11 |

|---|---|

| NTP(Next Token Prediction) 모델 이해 (0) | 2024.08.11 |

| 딥러닝 - 뉴런(Neuron)이란? 개념 이해 (0) | 2024.08.11 |

| LLM - Pre-train과 Fine-tuning 기본 이해 (0) | 2024.08.11 |

| Transformers - 구조와 BERT, GPT 이해 (0) | 2024.08.11 |