반응형

Gaussian Error Linear Unit (GELU)의 activation 수식

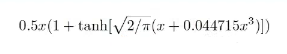

Gaussian Distribution을 다음 수식으로 위 수식의 복잡도를 낮추어 아래와 같이 근사(Approximation) 수식을 활용한게 된다.

근사(Approximation) 수식을 코드로 구현하면 다음과 같다.

import math

import tensorflow as tf

cdf = 0.5 * (1.0 + tf.tanh( (math.sqrt (2 / math.pi) * (x + 0.044715 * tf.pow(x, 3)))))반응형

'Bigdata' 카테고리의 다른 글

| LLM - Pre-train과 Fine-tuning 기본 이해 (0) | 2024.08.11 |

|---|---|

| Transformers - 구조와 BERT, GPT 이해 (0) | 2024.08.11 |

| LLM - fine-tuning GPT 계열 공식 이해 (0) | 2024.08.11 |

| PEFT(Parameter Efficient Fine-Tuning) - LoRA, QLoRA (0) | 2024.08.11 |

| 딥러닝 - 텐서(Tensor)란? (0) | 2024.08.11 |