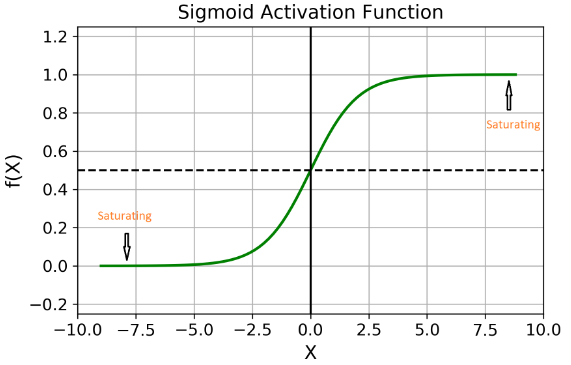

RNN의 단점으로 지적되는 기울기 소실, 장기 의존성 문제은 Sigmold Activation Function과 관계가 있고 RNN에서 닥 시계열 데이터를 입력할 때 기울기를 위해 Sigmoid Activation을 진행하는데, 아래 그림과 같이 올라가거나 내려갈수록 점점 1혹은 0과 큰 차이가 없어진다는 것이다.

기울기 소실(vanishing gradient): RNN은 입력과 출력 사이의 연결이 순환 구조로 되어 있기 때문에, 역전파를 통해 가중치를 업데이트할 때 기울기가 점차 소실되었어. 기울기가 소실되면, 가중치가 제대로 업데이트되지 않아 학습이 어려워 진다

장기 의존성 문제(long-term dependency problem): RNN은 과거의 정보를 기억하고 이를 바탕으로 현재의 정보를 처리하기 때문에, 과거의 정보가 현재의 정보에 영향을 미쳐야 한다. 하지만, RNN은 기울기 소실 문제 때문에 과거의 정보가 현재의 정보에 영향을 미치기 어려워지게 된다.

병렬 처리의 어려움: 이외에도 부가적으로 RNN은 입력이 순차적으로 들어오기 때문에 병렬 처리가 어려웠고, 이로 인해 학습 속도가 느리다.

이러한 단점들을 보완하기 위해 다양한 변형된 RNN들이 등장했는데, 대표적으로 다음과 같다.

LSTM(Long Short-Term Memory): RNN의 기울기 소실 문제를 해결하기 위해 도입된 모델로, 셀 게이트와 기억 게이트를 도입하여 과거의 정보를 기억할 수 있도록 했다.

GRU(Gated Recurrent Unit): LSTM과 유사하지만, 구조가 간단하고 학습이 빠른 모델로, 셀 게이트와 인풋 게이트를 도입하여 과거의 정보를 기억할 수 있도록 했다.

'Bigdata' 카테고리의 다른 글

| PEFT(Parameter Efficient Fine-Tuning) - LoRA, QLoRA (0) | 2024.08.11 |

|---|---|

| 딥러닝 - 텐서(Tensor)란? (0) | 2024.08.11 |

| 머신러닝 - 결정계수와 과대/과소적합 (0) | 2024.08.11 |

| FFNN - 순방향 신경망(feedforward neural network) (0) | 2024.08.11 |

| OpenAI 등, 문서 요약, Text Summarization API 사이트들 (4) | 2024.08.11 |